Los modelos de inteligencia artificial podrían “colapsar” en apenas unas pocas generaciones si se los entrena con datos que ellos mismos generan.

Un nuevo estudio publicado en Nature modeló lo que sucede con varios tipos diferentes de IA, incluidos los grandes modelos de lenguaje como los que sustentan ChatGPT, si se quedan sin información producida por humanos y comienzan a entrenarse con datos que ellos mismos generan.

Los investigadores descubrieron que los modelos se degeneran rápidamente, pierden sus capacidades originales y desencadenan un “efecto cascada” de errores compuestos.

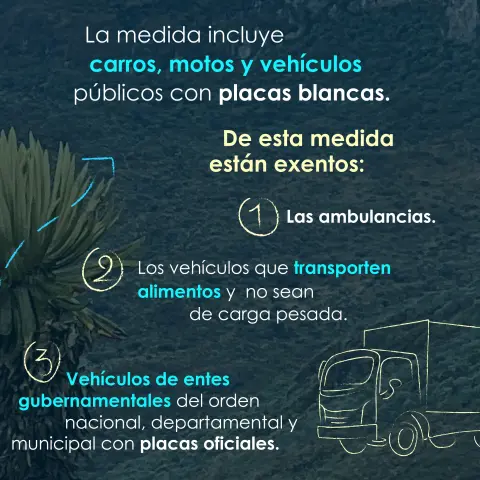

A medida que más de Internet se convierte en material generado por IA que luego se retroalimenta a los modelos, podría haber un punto de inflexión en el que el contenido en línea se “envenene”, advirtieron los investigadores, y se vuelva más difícil o incluso imposible acceder a información real y original.

Traducido de SEMAFOR

AI models collapse when trained on recursively generated data

Nature volume 631, pages755–759 (2024) Cite this article