Cualquier líder de redacción que esté pensando en cómo utilizar la IA debería leer los reflexivos consejos del zar de la IA del New York Times, Zach Seward.

Destaca tanto errores crudos (la “mentira sobre una mentira sobre una mentira” de Sports Illustrated) como formas en que los periodistas han utilizado lo que ahora llamamos IA durante años, como la notable exposición de Peter Aldhous de 2017 sobre los aviones espías nacionales.

Conclusiones de Seward: con supervisión humana, “los LLM son herramientas útiles para resumir texto, obtener información, comprender datos y crear estructuras”.

AI News That’s Fit to Print

La forma en que las organizaciones de noticias decidan aprovechar la inteligencia artificial determinará si el periodismo de alta calidad es destruido por la tecnología o, por el contrario, prospera. Afortunadamente, la elección está en manos humanas. En esta charla del director editorial de iniciativas de IA de The New York Times, analizaremos algunos de los mejores y peores usos del aprendizaje automático para el periodismo, y propondremos principios para un uso ético y eficaz de las noticias impulsadas por IA. Puedes escuchar al Speaker: haciendo click aquí o presionando la imagen

Zach Seward

Director editorial de iniciativas de IA

The New York Times

Zach Seward es el director editorial de iniciativas de IA en The New York Times, responsable de las nuevas formas de periodismo que posibilita la inteligencia artificial. Anteriormente, fue cofundador de la organización de noticias de negocios Quartz, donde ocupó varios puestos de liderazgo, como jefe de producto, redactor jefe y director general, durante más de una década. También ha trabajado en The Wall Street Journal y en el Nieman Journalism Lab de Harvard.

Al ser tema de interés, nos tomamos la molestia de hacer la traducción del artículo publicado por el Instituto Reuters para el Estudio del Periodismo y publicarlo en nuestro portal.

Primero hicimos un bosquejo de posibles titulares con sus respectivas bajadas:

- Título: “Navegando las Aguas del Periodismo con IA: Lecciones del Director Editorial de Iniciativas de IA del New York Times”

- Bajada: Zach Seward, líder de iniciativas de IA en The New York Times, ofrece una perspectiva reflexiva sobre cómo el periodismo puede beneficiarse de la inteligencia artificial. Desde los errores crudos hasta los usos más inspiradores, Seward destaca la importancia de la supervisión humana y la ética en la implementación de IA en las salas de redacción.

- Título: “El Futuro del Periodismo: Perspectivas desde la Vanguardia de la IA”

- Bajada: Únase a Zach Seward del New York Times mientras explora el impacto de la inteligencia artificial en el periodismo. Desde la identificación de patrones en grandes conjuntos de datos hasta la creación de modelos transformadores, Seward destaca cómo la IA está transformando la narrativa noticiosa y ofrece principios para su uso ético y efectivo.

- Título: “IA y Periodismo: Un Análisis desde Dentro del New York Times”

- Bajada: Zach Seward, director editorial de iniciativas de IA en el New York Times, comparte su visión sobre el papel de la inteligencia artificial en el periodismo actual. Desde errores a lecciones aprendidas, hasta usos innovadores y éticos, Seward ofrece una perspectiva única sobre cómo la IA está moldeando el futuro de las noticias.

- Título: “Haciendo Bien el Periodismo con IA: Lecciones del Zar de la IA del New York Times”

- Bajada: Zach Seward del New York Times ofrece una mirada crítica sobre el matrimonio entre periodismo e inteligencia artificial. Desde advertencias sobre la falta de supervisión hasta ejemplos inspiradores de buen uso, Seward aboga por un enfoque ético y reflexivo en la integración de la IA en la práctica periodística.

Noticias de IA aptas para imprimir: el nuevo líder de IA del New York Times explica lo que esta poderosa tecnología puede hacer por el periodismo

Zach Seward 13 de marzo de 2024

“El periodismo de IA fracasa cuando no está controlado, es perezoso, egoísta y opaco. Tiene que ser examinado y motivado por lo que es mejor para los lectores”, dice Zach Seward

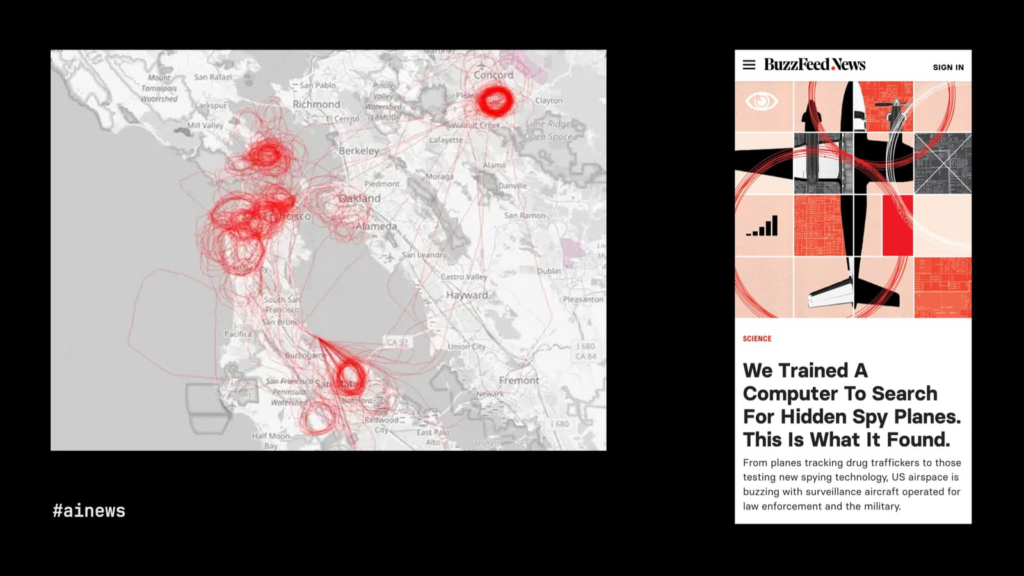

Generó imágenes de los patrones de vuelo que recopiló y pidió a un modelo de aprendizaje automático que buscara aviones espías ocultos.

Estas son las diapositivas, el guión y las referencias de una charla que Zach Seward dio recientemente en SXSW , una conferencia anual celebrada en Austin, Texas. Fue su primera presentación pública desde que comenzó su nuevo trabajo en el ‘New York Times’ y se publicó por primera vez en su blog personal . Lo republicamos aquí con su permiso. Instituto Reuters para el Estudio del Periodismo

Mi nombre es Zach Seward y soy el director editorial de iniciativas de IA en el New York Times , donde estoy formando un equipo de redacción encargado de crear prototipos de usos potenciales del aprendizaje automático en beneficio de nuestros periodistas y lectores. Antes de eso, cofundé y pasé más de una década ayudando a dirigir la startup de noticias empresariales Quartz, donde construimos muchos productos de noticias experimentales, algunos con IA.

Empecé en el Times hace menos de tres meses, así que no esperen demasiados detalles sobre en qué estamos trabajando; ni siquiera lo sé todavía. En cambio, lo que pensé que sería útil es examinar el estado actual del periodismo impulsado por IA, desde muy malo hasta realmente bueno, y tratar de extraer algunas lecciones de esos ejemplos. Hoy solo hablo por mí, pero esto ciertamente refleja cómo pienso sobre el papel que la IA podría desempeñar en la sala de redacción del Times y más allá.

Comenzaré con lo malo y lo feo, porque realmente creo que hay lecciones importantes que extraer de esos errores. Pero dedicaré la mayor parte de mi tiempo a usos realmente fantásticos e inspiradores de la inteligencia artificial para el periodismo, tanto en usos de lo que podríamos llamar modelos “tradicionales” de aprendizaje automático, que son excelentes para encontrar patrones en grandes cantidades de datos, como en También algunos usos recientes excelentes de modelos transformadores, o IA generativa, para servir mejor a periodistas y lectores.

Cuando el periodismo de IA sale mal

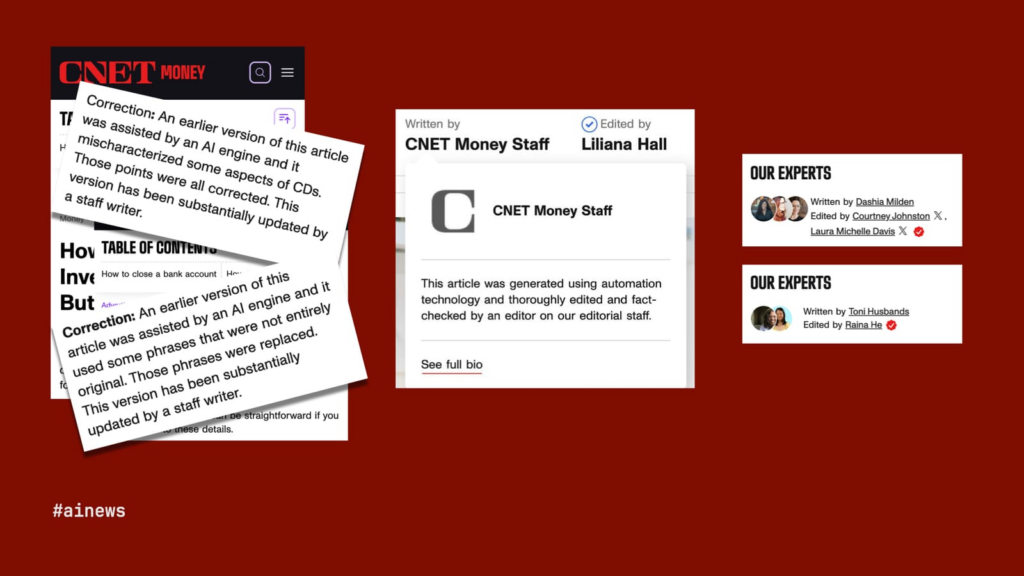

CNET (Empresas Rojas)

Así que comencemos con esos errores. En enero pasado, se reveló que CNET, el sitio de noticias tecnológicas propiedad de Red Ventures, estaba publicando consejos financieros (cuánto invertir en certificados de depósito (CD), cómo cerrar su cuenta bancaria, etc.) utilizando lo que llamó “automatización”. tecnología”, aunque la firma simplemente decía: “Escrito por el personal de CNET Money”.

Los artículos estaban plagados de errores emblemáticos de las alucinaciones de los llamados modelos de lenguaje grande (LLM) y tuvieron que ser corregidos. Algunos de los artículos también plagiaron de otras fuentes, otro error de escribir copias enteras con IA generativa. Seis meses después, los mismos artículos fueron actualizados minuciosamente por humanos cuyos nombres y fotografías ahora aparecen en el área de firma bajo el orgulloso título “Nuestros expertos”.

Creo que este tipo de contenido de asesoramiento ha atraído algunos de los peores ejemplos, porque los editores ya lo ven como un cuasi periodismo que realmente existe sólo para conseguir que compres un CD o abras una nueva cuenta bancaria a través de uno de sus enlaces de afiliados. . No suele tener en cuenta los verdaderos intereses del lector, por lo que ¿a quién le importa si el texto está mal escrito por un robot? Este patrón se repite mucho. Aquí están algunos ejemplos:

- Futurismo: ” CNET publica silenciosamente artículos completos generados por IA “

- The Verge: ” Dentro de la máquina de hacer dinero SEO impulsada por IA de CNET “

- CNET: ” La cantidad que usted debe invertir en un CD varía, pero no exceda esta cantidad “

- CNET: ” Cómo cerrar una cuenta bancaria “

Gizmodo y The Inventory (G/O Media)

Ahora hablaré de G/O Media, y aquí debo revelar que vendí Quartz a esta empresa y pasé un año trabajando en la empresa, aunque antes de cometer estos errores vergonzosos. G/O Media tenía una idea similar sobre la IA generativa: podía hacer el trabajo del periodismo de manera mucho más eficiente que los periodistas.

Naturalmente, G/O Media comenzó con su título más grande y conocido, Gizmodo, y utilizó un LLM para crear un contenido verdaderamente original: una lista cronológica de la franquicia Star Wars. Pero el “Gizmodo Bot”, como decía la firma, no era el droide que la compañía estaba buscando. Tenía un trabajo y, como los fanáticos obsesionados con Star Wars en Internet se apresuraron a señalar, falló y se equivocó en la cronología.

Castigado por ese error de alto perfil, G/O Media se alejó en gran medida de sus experimentos de IA, pero hasta el día de hoy continúa publicando una serie de artículos escritos por robots en su sitio de recomendación de productos, The Inventory , pregonando ofertas como 94,43 % de descuento en un libro de texto sobre gestión de la cadena de suministro y grandes ahorros en aceite de serpiente para tu cabello. Más irritante es parte del texto de estos artículos, en el que “The Inventory Bot” se refiere a sí mismo como un emprendedor y sugiere que los productos están “probados y son confiables”. Sólo una breve línea al final de cada artículo revela (o, en realidad, niega) que “este artículo fue generado por un motor de inteligencia artificial, que puede producir información inexacta”. Puede que sí, pero vale la pena por los ingresos de la filial de agua de arroz. Aquí hay unos ejemplos:

- Variedad: ” io9 de Gizmodo publicó un artículo de Star Wars generado por IA que estaba lleno de errores “

- Gizmodo: ” Una lista cronológica de películas y programas de televisión de Star Wars “

- El inventario: ” Tecnología innovadora en la interfaz de finanzas y operaciones: Volumen II (Serie Springer sobre gestión de la cadena de suministro, ahora con un 94,43 % de descuento “

- El inventario: ” Spray IQ Natural Rice Water para el crecimiento del cabello, ahora con un 38 % de descuento “

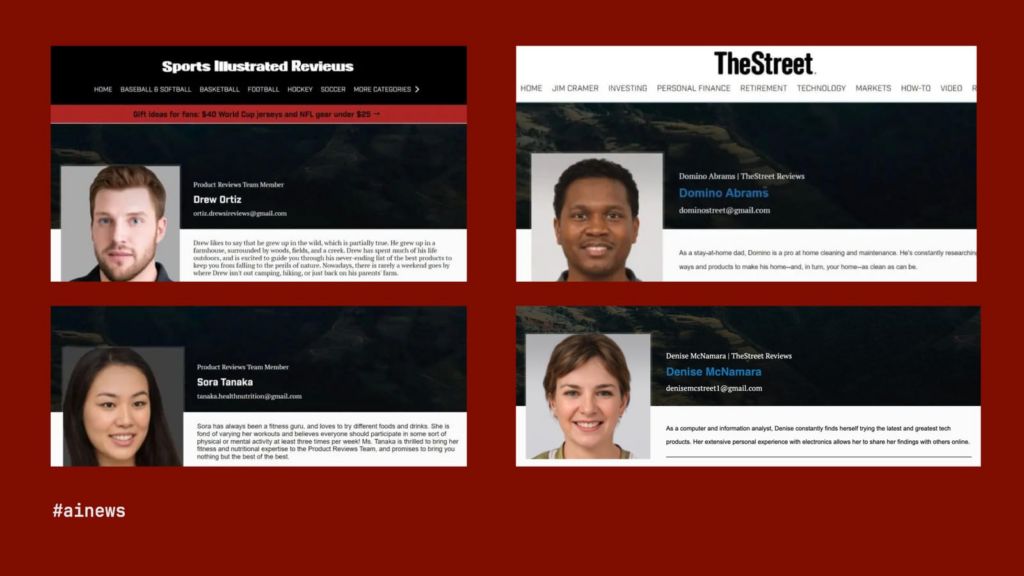

Sports Illustrated y The Street (Grupo Arena)

Entiendes la idea. Arena Group, que obtuvo la licencia de Sports Illustrated y es propietario de The Street, fue sorprendido recientemente haciendo algo similar con sus reseñas escritas por IA. El giro adicional aquí fue que Drew, Sora, Domino y Denise no existen. Sus fotografías fueron tomadas de un sitio de imágenes de archivo. Una mentira encima de una mentira encima de una mentira. Aquí están algunos ejemplos:

- Futurismo: ” Artículos publicados por Sports Illustrated por escritores falsos generados por IA “

- Sports Illustrated , a través de Internet Archive: ” Juega como un profesional con las mejores pelotas de voleibol de tamaño completo “

- The Street, a través de Internet Archive: ” ¿ Cómo mejorar su situación financiera? “

Cómo sale mal el periodismo de IA

No sólo estoy tratando de golpear a estas empresas, aunque se lo merecen. De hecho, creo que podemos extraer algunas lecciones útiles. Hay algunas cualidades comunes en estos malos ejemplos: la copia no está marcada; el planteamiento, lo más perezoso posible; la motivación, enteramente egoísta; la presentación, deshonesta y/u opaca.

El periodismo de IA fracasa cuando no está controlado, es vago, egoísta, deshonesto y opaco. Entonces, ¿cómo podríamos pensar en un periodismo con IA que funcione? Hay que examinarlo de forma rigurosa. La idea debe estar motivada por lo que es mejor para los lectores. Y, sobre todo, deben aplicarse los primeros principios del periodismo: verdad y transparencia.

Afortunadamente, tenemos muchos ejemplos de este tipo en una amplia gama de editores que utilizan tanto el aprendizaje automático (ML) tradicional como la IA generativa. Así que entremos en ellos.

Reconocer patrones con aprendizaje automático

Quartz

Comenzaré con un ejemplo que me resulta muy cercano, porque lo publicamos en Quartz en 2019. Estábamos trabajando con el Consorcio Internacional de Periodistas de Investigación , que había recibido una enorme cantidad de documentos, demasiado grandes para que cualquier ser humano pudiera revisarlos. -por página – de firmas de abogados que se especializan en ocultar riqueza en el extranjero. Estos documentos en particular procedían del paraíso fiscal insular de Mauricio.

Dado que no fue posible leer todos los documentos, que incluían declaraciones de impuestos, datos financieros y memorandos legales, mis colegas Jeremy Merrill y John Keefe crearon una herramienta que podría considerarse como “control-F con esteroides”. El personal del ICIJ con experiencia en evasión fiscal identificó pasajes de particular interés en una muestra de los documentos.

Luego, Jeremy convirtió el texto sin formato de todos los documentos en vectores con matrices como las que se ven arriba, usando un modelo llamado doc2vec . Este también es el primer paso de cómo funcionan los modelos de transformadores. Al transformar las filtraciones de Mauricio en un espacio multidimensional, pudimos identificar de repente otros documentos que eran similares, aunque no exactamente iguales, a los documentos de interés originales. El modelo podría identificar patrones que ningún humano sería capaz de detectar.

Hizo que el trabajo de examinar las filtraciones de Mauricio no sólo fuera más eficiente, sino que, de hecho, fuera posible. Estamos hablando de 200.000 documentos extremadamente técnicos. No puedes simplemente leer eso página por página. Necesitas la ayuda de una máquina. Aquí están los enlaces relevantes:

- Quartz: ” Cómo Quartz utilizó la IA para ayudar a los periodistas a buscar las filtraciones de Mauricio “, por Jeremy B. Merrill

- GitHub: ” Quartz AI Studio: Doc2vec para periodismo de investigación “, por Jeremy B. Merrill

- Consorcio Internacional de Periodistas de Investigación: ” Mauricio Leaks “

Grist y el ‘Texas Observer’

El Texas Observer y Grist, una sala de redacción sin fines de lucro dedicada a la cobertura ambiental, hicieron algo similar con su investigación de pozos petroleros abandonados en Texas y Nuevo México. Estos se contaban por decenas de miles, por lo que visitar cada uno de ellos estaba fuera de discusión. Pero tenían datos sobre los pozos, tanto los aproximadamente 6.000 pozos que los estados ya habían marcado como abandonados como decenas de miles de pozos adicionales que parecían similares.

El aprendizaje automático es, en esencia, solo matemáticas avanzadas, y Clayton Aldern de Grist empleó modelos estadísticos para comparar las condiciones en torno a la lista oficial de pozos abandonados con un conjunto de datos de sitios mucho más grande. Encontraron al menos 12.000 pozos adicionales en Texas que estaban abandonados pero no registrados. Aquí están los enlaces relevantes:

- Grist: ” Cómo calculamos el tamaño del problema de los pozos petroleros abandonados en el suroeste “, por Clayton Aldern y Naveena Sadasivam

- GitHub: ” Olas de abandono “, por Clayton Aldern

- Grist y The Texas Observer: ” Waves of Abandonment “, de Clayton Aldern, Christopher Collins y Naveena Sadasivam

Noticias BuzzFeed

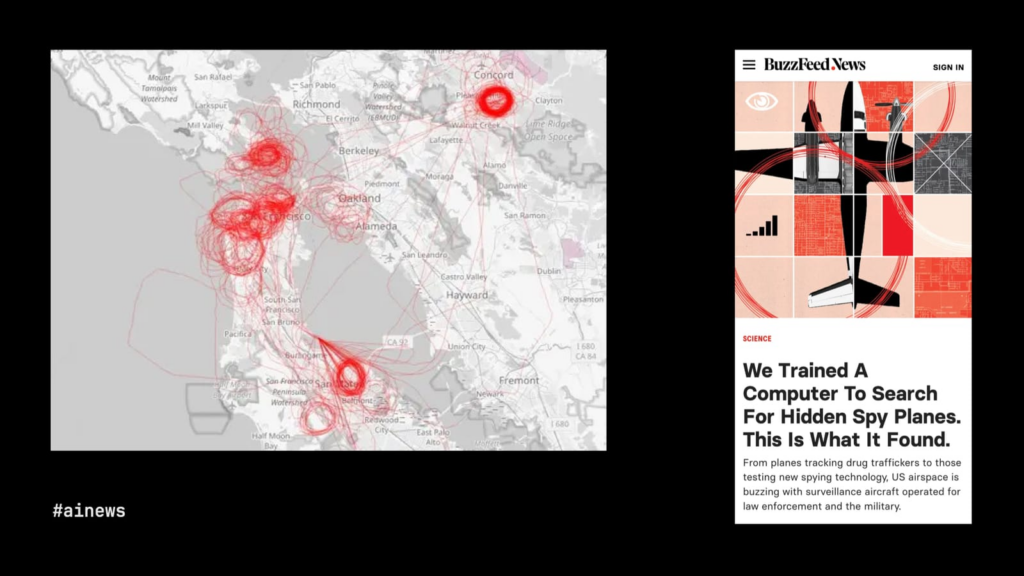

Entonces, en esos dos ejemplos, los periodistas identificaron patrones en el texto y patrones en los datos numéricos. El siguiente ejemplo es genial porque Peter Aldhous , del antiguo BuzzFeed News, tenía muchos datos de vuelo disponibles públicamente y una visión muy aguda: los aviones normalmente vuelan del punto A al punto B, pero cuando rodean un área una y otra vez , es probable que el avión esté allí para espiar.

Entonces, Aldhous generó imágenes de los patrones de vuelo que recopiló y le pidió a un modelo de aprendizaje automático entrenado en reconocimiento de patrones que encontrara los círculos. Y, por supuesto, ni siquiera los aviones espía vuelan en bucles perfectos, por lo que la capacidad del modelo para identificar círculos y casi círculos, para trabajar dentro de los bordes ásperos de la realidad, fue crucial. La investigación encontró una gran cantidad de vigilancia, por parte de aviones gubernamentales y privados, que se realiza regularmente en las principales ciudades de Estados Unidos. Aquí están los enlaces relevantes:

- BuzzFeed News: ” Entrenamos una computadora para buscar aviones espía ocultos. Esto es lo que encontró “, por Peter Aldhous

- GitHub: ” BuzzFeed News entrenó a una computadora para buscar aviones espía ocultos. Esto es lo que encontramos “, por Peter Aldhous

El periodico de Wall Street’

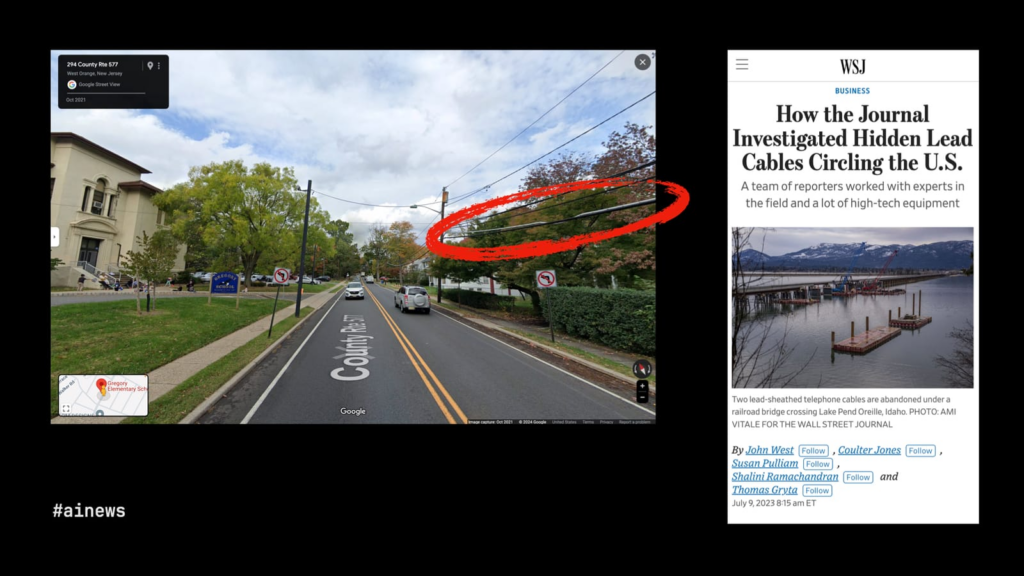

El reconocimiento de imágenes es una poderosa herramienta para el periodismo de investigación. El Wall Street Journal lo utilizó con gran efecto en una serie de artículos sobre cuánto cableado de plomo queda en los EE. UU., mucho después de que nos dimos cuenta de los graves peligros del plomo.

Un aspecto de la investigación, dirigida por John Bebe-West, utilizó imágenes de Google StreetView en escuelas de Nueva Jersey. Ahora, para ti y para mí, esto parece un suburbio idílico en un día parcialmente nublado. Pero para un modelo de aprendizaje automático entrenado en cómo se ve el cableado principal, es una crisis de salud pública. El Journal encontró una gran cantidad de cableado de plomo en áreas públicas de todo el país y fue a muchos de esos lugares para realizar pruebas reales de exposición al plomo, que en muchos casos encontraron niveles extremadamente altos.

No podemos poner un periodista en cada esquina de Estados Unidos, pero gracias a la IA, en cierto modo podemos. Aquí están los enlaces relevantes:

- The Wall Street Journal : ” Cómo el diario investigó los cables conductores ocultos que circulan por los EE. UU .”, por John West, Coulter Jones, Susan Pulliam, Shalini Ramachandran y Thomas Gryta

- The Wall Street Journal : ” El legado del líder “

Los New York Times’

Del mismo modo, no tenemos muchos periodistas en el espacio, al menos no todavía, pero sí tenemos voluminosas imágenes tomadas desde el cielo y disponibles casi en tiempo real de nuevas empresas que han lanzado satélites a órbita baja durante la última década.

Mis colegas del New York Times han utilizado esas imágenes de satélite para realizar investigaciones realmente increíbles. Por ejemplo, después de que estalló la guerra entre Israel y Gaza, nuestro equipo de investigaciones visuales quiso dar cuenta de la campaña de bombardeos de Israel en el sur de Gaza, que era la supuesta zona segura de la guerra. No hubo un informe oficial sobre cuántas bombas poderosamente destructivas se habían lanzado allí, pero las bombas dejan cráteres, por lo que el Times programó una herramienta de inteligencia artificial para analizar imágenes satelitales del sur de Gaza en busca de cráteres de bombas.

La herramienta de IA detectó más de 1.600 posibles cráteres. Revisamos manualmente cada uno para eliminar lo falso, como sombras, torres de agua o cráteres de bombas de un conflicto anterior. Medimos los cráteres restantes para encontrar aquellos que medían aproximadamente 40 pies de ancho o más y que, según los expertos, generalmente están formados solo por bombas de 2000 libras. Al final, identificamos 208 de estos cráteres en imágenes satelitales y filmaciones de drones, lo que indica que las bombas de 2000 libras representaban una amenaza generalizada para los civiles que buscaban seguridad en todo el sur de Gaza.

Esa parte del trabajo estuvo dirigida por Ishaan Jhaveri . Es un gran ejemplo de una historia que simplemente no podría haberse contado sin el aprendizaje automático junto con periodistas y expertos.

- The New York Times: ” Una investigación del Times rastreó el uso por parte de Israel de una de sus bombas más destructivas en el sur de Gaza “, por Robin Stein, Haley Willis, Ishaan Jhaveri, Danielle Miller, Aaron Byrd y Natalie Reneau

- The New York Times: ” Investigaciones visuales “

Cómo puede ayudar el aprendizaje automático

Hemos visto cómo los modelos de aprendizaje automático funcionan mejor para el periodismo cuando reconocen patrones que el ojo humano por sí solo no puede ver. Patrones en texto, datos, imágenes de datos, fotografías en el suelo y fotografías tomadas desde el cielo.

Por supuesto, mucho de esto ha sido posible durante muchos años. Pero hay algunos usos igualmente inspiradores de la nueva tecnología de aprendizaje automático, los grandes modelos de lenguaje (LLM) o la IA generativa. Si el aprendizaje automático tradicional es bueno para encontrar patrones en una masa de datos, se podría decir que el superpoder de la IA generativa es crear patrones. Entonces, veamos algunos ejemplos de esto en acción para las noticias.

Creando sentido con IA generativa

El proyecto Marshall

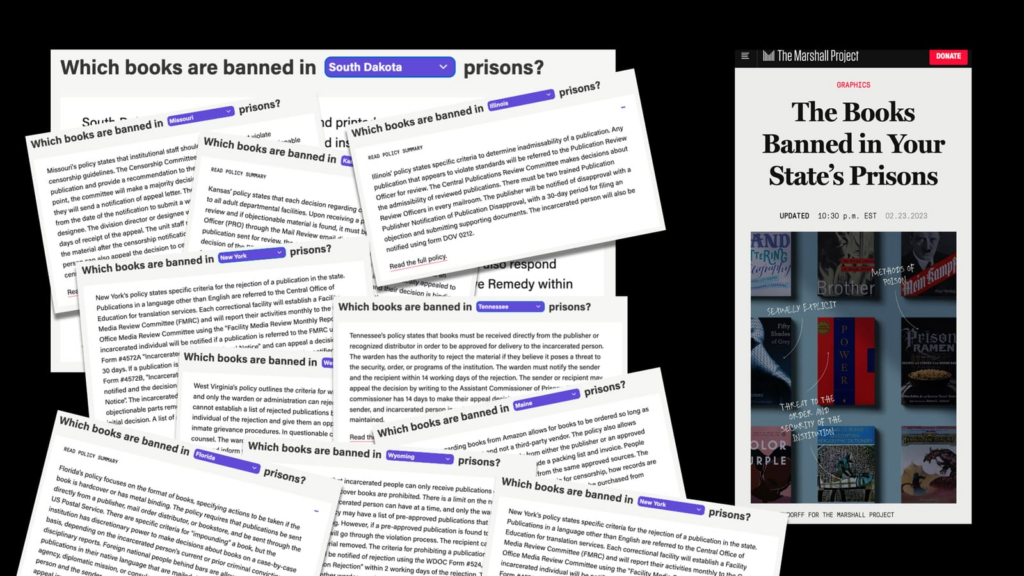

El Proyecto Marshall, una sala de redacción sin fines de lucro que cubre el sistema judicial estadounidense, ha estado investigando qué libros están prohibidos en las prisiones estatales y por qué. Mantiene una base de datos de los libros reales, pero también tiene en sus manos las políticas oficiales que guían la prohibición de libros en 30 sistemas penitenciarios estatales.

A menudo se trata de documentos extensos y esotéricos, y el Proyecto Marshall quería que las políticas fueran más accesibles para los lectores interesados. Sus periodistas revisaron cada documento para identificar las partes que realmente importaban, y luego Andrew Rodríguez Calderón , utilizando GPT-4 de OpenAI, empleó una serie de indicaciones muy específicas para generar resúmenes útiles y legibles de las políticas. Luego, los periodistas volvieron a revisar esos resúmenes antes de su publicación.

Si sólo hubieran necesitado resumir una política estatal, podría haber sido más sencillo hacerlo todo a mano. Pero al utilizar un LLM, el Proyecto Marshall podría generar dichos resúmenes en los 30 estados de los que obtuvo políticas. Aquí están los enlaces relevantes:

- El Proyecto Marshall: ” Los libros prohibidos en las prisiones de su estado “, por Keri Blakinger, Ryan Murphy, Elan Kiderman Ullendorff y Andrew Rodriguez Calderón

- IA generativa en la redacción: ” Decodificando la burocracia “, por Andrew Rodríguez Calderón

Informes de vigilancia en Filipinas

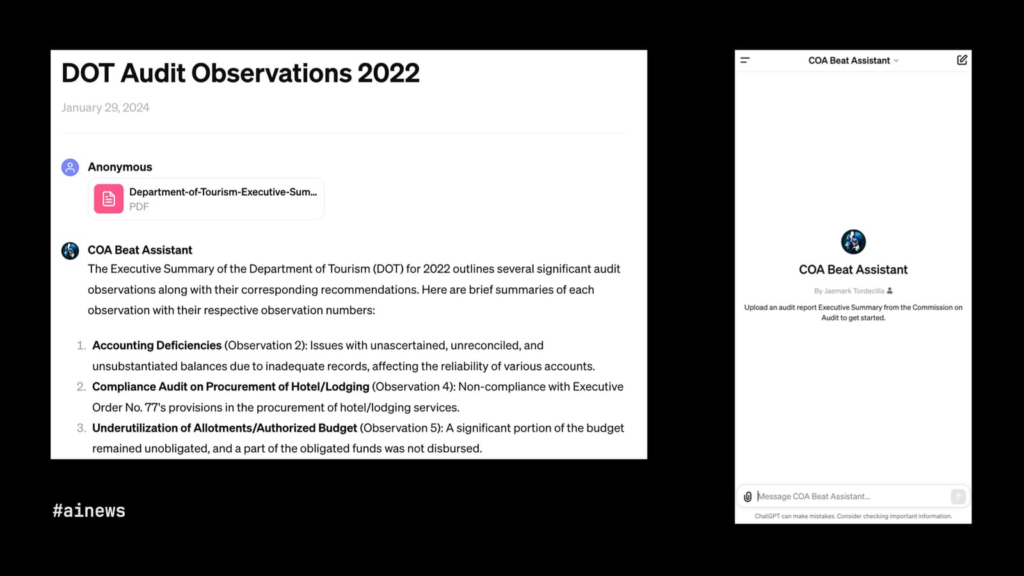

Jaemark Tordecilla , un periodista filipino que actualmente es miembro de la Fundación Nieman, tuvo un éxito similar al decodificar documentos burocráticos con un LLM. Creó un GPT personalizado capacitado para resumir informes de auditoría de agencias gubernamentales en Filipinas. Estos informes suelen revelar pruebas de corrupción, pero son muy largos y difíciles de leer. Ahora, varios periodistas filipinos están utilizando la herramienta de Jaemark para identificar corrupción y encontrar nuevas líneas de información prometedoras.

- OpenAI: ” COA Beat Assistant “, de Jaemark Tordecilla

- Instituto Reuters: ” Creé una herramienta de inteligencia artificial para ayudar a los periodistas de investigación a encontrar historias en informes de auditoría. Así es como lo hice y por qué es importante “, por Jaemark Tordecilla

Tiempo real

Pero creo que la mayoría de las personas, cuando escuchan IA generativa para el periodismo, imaginan sitios de noticias completamente automatizados, como algunos de los malos ejemplos que vimos antes. Bueno, aquí hay un sitio totalmente automatizado que realmente creo que hace un buen trabajo brindando valor, sabiendo sus limitaciones y utilizando la cantidad justa de IA.

Se llama Realtime , un sitio de noticias de Matthew Conlen y Harsha Panduranga , que muestra datos actualizados periódicamente de mercados financieros, deportes, registros gubernamentales, mercados de predicción, encuestas de opinión pública… Los datos y gráficos están completamente automatizados. El sitio intenta resaltar gráficos que muestran datos interesantes, como un valor atípico o un crecimiento o declive particularmente fuerte. Hasta ahora, matemáticas interesantes pero básicas.

Donde los LLM desempeñan un papel es en proporcionar contexto: los titulares y otros textos breves que aparecen alrededor de los gráficos para ayudar a los lectores a comprender lo que están viendo. La calidad del aire en Nueva York hoy es buena, el número de usuarios del metro todavía está por debajo de los niveles previos a la pandemia pero, lo positivo, nuestra lucha contra las ratas está mostrando avances.

Estos son casos de uso realmente específicos para un LLM, y se revela completamente el hecho de que un bot escribió estos informes. No es una investigación profunda sobre la guerra contra las ratas, que también me encantaría leer, pero sin duda es una forma útil de controlar la propia ciudad. Aquí están los enlaces relevantes:

- Tiempo real , de Matthew Conlen y Harsha Panduranga

- Tiempo real: ” La ciudad de Nueva York, un informe en tiempo real “, de Realtime Bot

- Realtime: ” Presentación de Realtime: análisis continuo y automatizado de datos públicos “, por Matthew Conlen y Harsha Panduranga

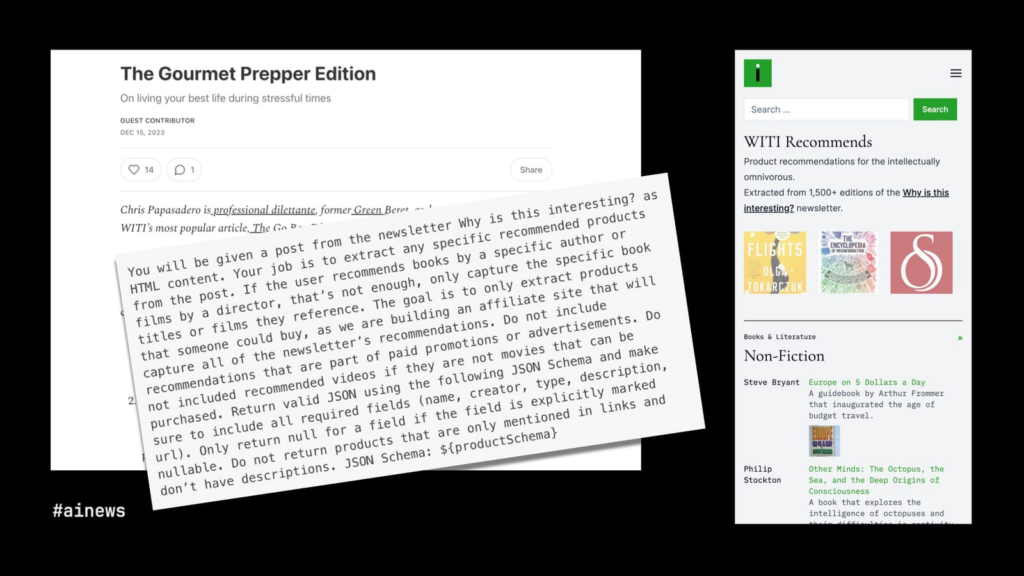

WITI recomienda

Aquí hay otro sitio web impulsado por un LLM, esta vez en segundo plano. ¿Por qué es esto interesante? Es un boletín diario muy popular que se publica desde hace cinco años y cuenta con muchos escritores invitados. Aunque no es exactamente el objetivo del boletín, cada edición tiende a hacer referencia a uno o más productos que le gustan al escritor. Lo que le dio a Noah Brier , uno de los cofundadores de WITI , la idea de recopilar todas esas recomendaciones.

El problema, por supuesto, fue que las “recomendaciones” estaban enterradas en una prosa no estructurada. A veces, los escritores vinculan productos que odian o cosas que no están a la venta. ¿Cómo podría Noah crear una base de datos con solo las recomendaciones de los productos a la venta en 1500 ediciones del boletín? La respuesta fue un mensaje cuidadosamente diseñado para GPT-4, que pudo extraer y clasificar las recomendaciones de productos en un formato listo para mostrar.

La gente mira herramientas como ChatGPT y piensa que su mayor truco es escribir para usted. Pero, de hecho, el caso de uso más poderoso de los LLM es lo opuesto: crear estructura a partir de prosa no estructurada. Aquí están los enlaces relevantes.

- WITI recomienda , por Noah Brier y Colin Nagy

- BrXnd Dispatch: ” IA como interfaz difusa “, por Noah Brier

- BrXnd Dispatch: ” Construyendo con IA “, por Noah Brier

- ¿Por qué es interesante?: ” La edición WITI recomienda “, por Noah Brier

Cómo puede ayudar la IA generativa

Estos últimos cuatro ejemplos, que utilizan IA generativa, nos dan una idea de la mayor promesa de la tecnología para el periodismo (y, yo diría, para muchos otros campos). Frente a la realidad caótica y desordenada de la vida cotidiana, los LLM son herramientas útiles para resumir textos, obtener información, comprender datos y crear estructuras.

Pero esto siempre debe hacerse con supervisión humana: guiar los resúmenes y luego verificar los resultados, enseñar al robot a navegar por un informe de auditoría, decidir cuándo y cuándo no poner el control del bot y diseñar el resto del software que impulsa el sistema. sitio. En todos estos casos, son los humanos primero y los humanos al final, con un poco de IA generativa y poderosa en el medio para marcar la diferencia.

Espero que estos ejemplos te inspiren, como me han inspirado a mí. Aquí está mi información de contacto . Si está trabajando en proyectos de periodismo de IA igualmente interesantes, me encantaría saber de usted.

Instituto Reuters para el Estudio del Periodismo

Instituto Reuters para el Estudio del Periodismo

Universidad de Oxford

13 Norham Gardens

Oxford, OX2 6PS

Reino Unido

Ponerse en contacto

T: +44 (0)1865 611080

E: reuters.institute@politics.ox.ac.uk