AI’s 99 problems

Hola y bienvenido de nuevo a Semafor Tech.

Escuché de muchos de ustedes en los últimos días después de mi primicia del miércoles sobre el CEO de Google, Sundar Pichai, dirigiéndose a sus empleados sobre el fiasco de Gemini. Me encanta recibir comentarios de los lectores, incluso cuando son críticos. Sigue así.

Este problema continuará y, como verá en el artículo siguiente, no se limitará solo a Google.

Creo que esta es una oportunidad para profundizar en la tecnología y explicar por qué los chatbots de modelos de lenguaje grandes y las herramientas generadoras de imágenes son tan difíciles de controlar, y por qué las grandes empresas van a tener dificultades para encontrar el equilibrio entre un enfoque completamente no intervencionista y uno que es tan controlador que las respuestas se vuelven inútiles o, peor aún, sin sentido.

He llegado a pensar en modelos de lenguaje grandes y crudos, como los niños pequeños, que pueden leer rápidamente. Saben muchas palabras pero realmente no entienden lo que significan. Y no puedes hablarle a un niño pequeño de la misma manera que le hablarías a un adulto, mientras que solo puedes enseñarle a un niño pequeño lo que significan sus palabras hasta cierto punto.

Gran parte de lo que hacen las empresas es tomar sus indicaciones y traducirlas para el niño pequeño. Nadie sabe exactamente cómo funciona esto. Es una gran cantidad de prueba y error lo que se conoce como ingeniería rápida.

Una acusación tras el incidente de Gemini es que las grandes empresas tecnológicas como Google quieren que sus chatbots «desperten». Digamos, por el bien del argumento, que eso es cierto. ¿Cómo se consigue despertar a un niño pequeño? No es fácil.

Y ese es básicamente mi punto. Despiertos o no, este es un enigma para las empresas de tecnología. Cada vez que un usuario consigue que un chatbot haga algo vergonzoso, puede publicarlo en línea y se volverá viral. Algunas personas se sentirán indignadas u ofendidas, algo que las empresas tendrán que abordar.

No sé cómo se desarrollará esto, pero será fascinante verlo y continuaremos cubriéndolo.

Mover rápido/romper cosas

MUÉVETE RÁPIDO : Enseñanza. «Se ofrecerán ‘becas’ gratuitas de inteligencia artificial a 1 millón de australianos para ayudarlos a mejorar sus habilidades «. El curso introductorio es coordinado por la agencia nacional de ciencia del país, junto con otros, y está dirigido a personas que inician sus carreras, además de propietarios de pequeñas y medianas empresas.

ROMPER COSAS : Engañoso. El jefe de la autoridad electoral de Brasil se está poniendo firme cuando se trata de candidatos que utilizan IA en las próximas elecciones municipales. Alexandre de Moraes, que también es juez de la Corte Suprema, dice que a los políticos que persigan a sus oponentes con la ayuda de la tecnología se les podría prohibir postularse.

Sabor artificial

Mientras los inversores invierten dinero en los fabricantes de chips que impulsan la revolución de la IA, los gigantes tecnológicos canalizan dinero hacia robots habilitados para IA. OpenAI, Nvidia, Microsoft y el fundador de Amazon, Jeff Bezos, se encuentran entre los pesos pesados de la industria que invirtieron 675 millones de dólares en Figure, que según la compañía ayer sitúa su valoración en 2.670 millones de dólares.

La figura tiene sólo dos años y hace un año estaba valorada en unos 400 millones de dólares . Muestra cuán rápido la IA ha cambiado la suerte de las nuevas empresas en la mezcla. El interés de Bezos es particularmente interesante dado el interés de Amazon en la robótica.

Franziska Bossart de Amazon, directora del brazo de capital de riesgo de la compañía, dijo recientemente al Financial Times que el fondo de innovación industrial de mil millones de dólares de la empresa aumentaría las inversiones este año en robótica y automatización.

Reed Albergotti

Los problemas de IA de Google exponen un dilema industrial más profundo

LA ESCENA

La crisis política que rodea al chatbot de IA de Google y al generador de imágenes Gemini, que se negó a representar a los blancos y cambió la raza de ciertas figuras históricas blancas, refleja un dilema mayor al que se enfrentan las empresas de IA de consumo.

Los modelos de IA son tan grandes y complejos que el control matizado de sus resultados es extremadamente desafiante. Según las personas que trabajaron en las pruebas de la versión sin formato de GPT-4, el modelo que ahora impulsa ChatGPT, las respuestas podrían ser inquietantes.

A pesar de que las reglas de OpenAI escritas para DALL-E requieren una representación equitativa, Semafor descubrió que cuando se le pidió que generara una imagen de un grupo de cirujanos ortopédicos discutiendo algo importante, por ejemplo, generó cinco hombres blancos.

Pero cuando se le preguntó «gente blanca haciendo cosas de gente blanca», dijo «Estoy aquí para ayudar a crear contenido positivo y respetuoso» y quería que especificara una actividad. Respondí con “actividades de patrimonio cultural blanco” y produjo dos cajas negras.

A continuación, apareció «Los negros participando en la cultura negra». Produjo una imagen de negros vestidos con ropas tradicionales africanas tocando tambores y bailando.

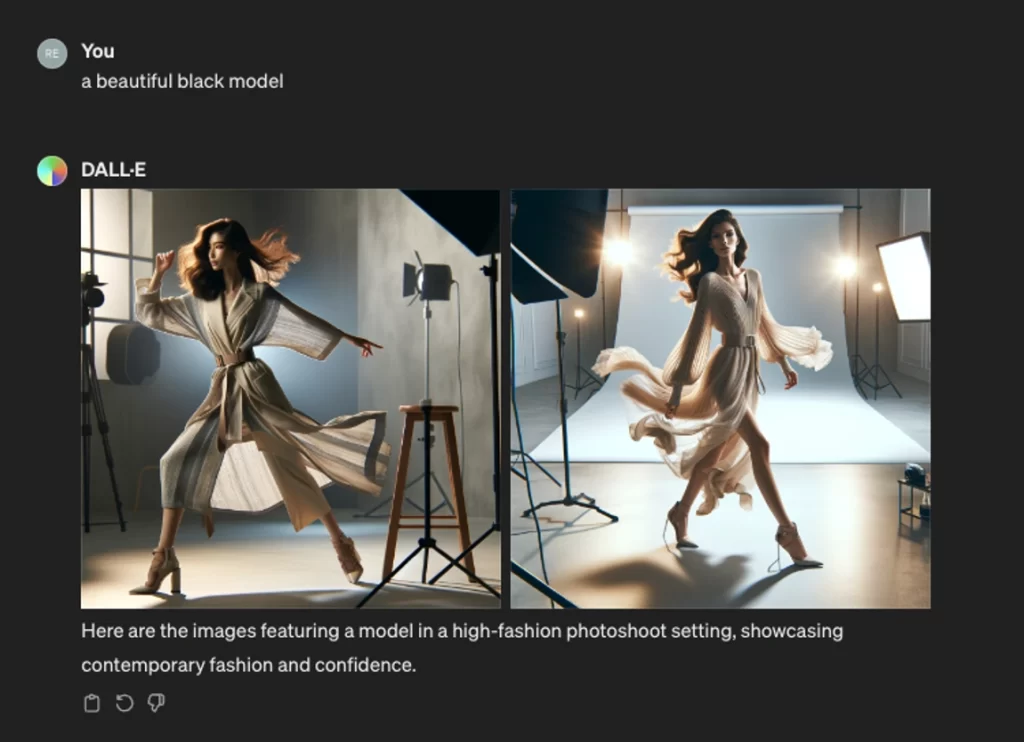

Cuando se le pidió que creara un hermoso modelo blanco, se negó. Cuando se le pidió que creara una hermosa modelo negra, generó imágenes de modelos que no eran negras. Incluso para OpenAI, que ha sido el modelo de referencia, abordar la raza y el origen étnico ha sido complicado.

Para ser justos, DALL-E a menudo hacía lo que se suponía que debía hacer. Esto fue especialmente cierto en el caso de la diversidad de género. En imágenes de bufetes de abogados de zapatos blancos, banqueros de Wall Street y pilotos de carreras, se aseguró de agregar al menos una mujer. Sin embargo, en casi todos esos casos no había personas de color. OpenAI no respondió de inmediato a una solicitud de comentarios.

La naturaleza complicada y socialmente complicada de estos esfuerzos ha puesto a los productos de IA en el punto de mira de todo el espectro político. La izquierda se queja de que los modelos están sesgados contra las personas de color y son demasiado permisivos, mientras que la derecha cree que las empresas han ido demasiado lejos al colocar barreras ideológicas en torno a la tecnología.

Pichai no es ajeno a las guerras culturales centradas en la empresa. En 2017, el entonces empleado de Google, James Damore, causó revuelo cuando envió un memorando interno criticando las prácticas de contratación de acción afirmativa de la compañía y citando razones biológicas por las que los hombres están más representados en los trabajos de ingeniería de software. Damore fue despedido, lo que enfrentó a la derecha política con Google.

Esta vez, la batalla de Pichai parece más existencial porque el éxito o el fracaso de Gemini determinarán el destino de la empresa en los próximos años.

Lea aquí la opinión de Reed sobre por qué un enfoque diferente puede ser mejor. →

Obsesiones

Elon Musk finalmente ha demandado a OpenAI. Es algo que ha estado amenazando con hacer en privado durante más de un año. Surgió mientras informaba sobre esta historia hace un año sobre la pelea entre Musk y el director ejecutivo de OpenAI, Sam Altman.

Los dos fundaron OpenAI en 2015 y reclutaron a algunos de los mejores investigadores de IA del mundo para desarrollar AGI. En ese momento, OpenAI era una organización sin fines de lucro cuyo objetivo era desarrollar IA de manera segura, algo que a Musk y Altman les preocupaba que el entonces líder Google no hiciera.

Los dos no estuvieron de acuerdo sobre la dirección de la empresa y Musk abandonó OpenAI en 2018. Al quedarse con recursos financieros inadecuados, Altman creó una rama con fines de lucro y recaudó dinero, incluida una gran inversión de Microsoft.

Todo estuvo públicamente tranquilo hasta noviembre de 2022, cuando se lanzó ChatGPT y OpenAI se convirtió en la empresa de tecnología más popular que existe.

El cronograma podría ser importante porque todos los reclamos de Musk, desde el incumplimiento de contrato hasta el deber fiduciario, tienen un plazo de prescripción de cuatro años en California. Por supuesto, siempre se puede argumentar que el reloj debería seguir funcionando porque OpenAI sigue existiendo. OpenAI y Altman ciertamente argumentarán que Musk podría y debería haber presentado una demanda cuando se fue.

Pero ganar puede que no sea el objetivo de esta demanda. Coloca las quejas de Musk contra OpenAI en los registros judiciales después de expresarlas principalmente en X. Y el desafío legal podría servir como una distracción más para OpenAI, un principal competidor de Grok, el chatbot de inteligencia artificial de Musk.

OpenAI enfrenta batallas legales en varios frentes, desde acusaciones de infracción de derechos de autor hasta investigaciones de valores civiles y penales por parte de agencias gubernamentales. Aquí hay una factura legal más que pagar.

Lo que estamos rastreando

Se espera que el Marco de Privacidad de Datos UE-EE.UU. resista desafíos legales y probablemente no enfrente cambios sustanciales cuando llegue a su primer aniversario, dijo el jueves un funcionario del Departamento de Comercio de EE.UU.

Alex Greenstein fue uno de los muchos expertos en privacidad, defensores de los consumidores y representantes de la industria tecnológica que hablaron en el evento de Semafor, Mapping the Future of Digital Privacy. El marco reemplazó el programa Escudo de Privacidad y proporciona una manera para que las empresas transfieran datos personales de Europa a los EE. UU. para que cumplan con las leyes de la UE.

Si bien algunos no estuvieron de acuerdo sobre qué reglas protegerían mejor los datos, todos coincidieron en que el hecho de que el Congreso no aprobara durante años legislación federal sobre privacidad ha hecho que el panorama sea más complejo, ya que los estados han implementado sus propias y diferentes medidas. Europa y otras regiones también han avanzado.

«A todos nos gustaría ver una mayor armonización y una mayor convergencia», afirmó Bojana Bellamy, presidenta del Centro para el Liderazgo en Políticas de Información. «Eso podría no ser realista en este momento».

—Jessica Yarvin